14일(현지시각) 미국 캘리포니아 마운틴뷰에서 열린 연례 개발자 회의 ‘구글 I/O 2024’에서 새로운 AI를 소개하고 있는 순다 피차이 구글 CEO. 사진제공|구글

한층 강화된 멀티모달 AI 기술 연이어 공개

구글 ‘제미나이’ 최신 버전 선보여

대화하듯 더 복잡한 검색도 가능

오픈AI 새모델 GPT-4o 베일벗어

사람표정 읽거나 수학문제 풀수도

영화 ‘her’ 속의 ‘사만다’, ‘아이언맨’ 시리즈의 ‘자비스’ 같은 ‘보고, 듣고, 말하는’ 인공지능(AI)이 온다. 글로벌 빅테크 기업들이 최근 한층 강화된 멀티모달 AI 기술을 연이어 공개했다. 멀티모달이란 텍스트를 인식해 텍스트로 답하던 것에서 벗어나 청각이나 시각 등 다양한 데이터를 이해하고 처리할 수 있는 AI를 말한다. 여기에 추론 성능과 반응 속도도 높여 마치 사람과 대화하 듯 정보를 얻을 수 있다. 구글 ‘제미나이’ 최신 버전 선보여

대화하듯 더 복잡한 검색도 가능

오픈AI 새모델 GPT-4o 베일벗어

사람표정 읽거나 수학문제 풀수도

●‘멀티모달’이란

텍스트를 인식해 텍스트로 답하던 것에서 벗어나 청각이나 시각 등 다양한 데이터를 이해하고 처리할 수 있는 AI

●구글 ‘제미나이’ 검색에 적용

구글은 14일(이하 현지시각) 미국 캘리포니아 마운틴뷰에서 연례 개발자 회의 ‘구글 I/O 2024’를 열고 새로운 AI 기술을 대거 선보였다.

먼저 구글은 이날 AI모델 ‘제미나이’의 다양한 최신 버전을 공개했다. 최상위 모델인 ‘제미나이 1.5 프로’의 경우 데이터 및 알고리즘 개선을 통해 코드 생성, 논리적 추론 및 계획, 멀티턴 대화, 오디오 및 이미지 인식 성능이 크게 향상됐다는 것이 구글 측 설명이다.

구글은 이날 검색 등 다양한 서비스에 ‘제미나이’를 탑재한다고도 밝혔다. 구글 검색에 새 제미나이 모델을 결합하면 단순 단어 검색을 넘어 AI 챗봇과 대화하듯 더욱 복잡한 검색도 가능하다. 또 이미지 검색을 넘어 비디오 검색까지 가능해질 전망이다.

구글은 이날 멀티모달 AI 에이전트 비전을 담은 ‘프로젝트 아스트라’도 공개했다. 일부 기능을 연내 제미나이 앱 등에 선보일 예정이다. 프로젝트 아스트라는 텍스트, 이미지, 영상, 음성 등 다양한 정보를 이해하고 처리하는 능력을 갖춘 AI 에이전트를 개발하는 프로젝트다. 특히 음성 모델을 활용해 자연스러운 대화와 빠른 반응 속도를 구현하는 데 집중했다. 구글은 이런 멀티모달 기술을 기반으로 모바일 기기나 스마트 안경을 통해 언제 어디서든 전문적인 도움을 제공하는 미래 AI 비서를 구현한다는 계획이다.

●오픈AI는 ‘GPT-4o’ 공개

오픈AI는 이보다 하루 앞선 13일 새 AI모델 ‘GPT-4o’를 공개했다. GPT-4o에서 ‘o’는 ‘모든’을 뜻하는 ‘옴니’(omni)의 앞글자에서 따왔다. GPT-4o는 기존에 비해 처리 속도가 2배가량 빨라진 것이 특징이다. 음성 반응 속도가 빠른 경우 232ms(밀리초·1000분의 1초), 평균 320ms로, 사람이 실제로 대화할 때와 비슷한 수준을 구현했다. 이를 통해 보다 자연스러운 대화가 가능하다는 게 오픈AI 측 설명이다. 또 새로운 AI는 문자는 물론 이미지와 음성을 모두 인식한다. 카메라를 이용해 사람의 얼굴 표정을 읽거나, 수학문제를 풀 수도 있다.

김명근 스포츠동아 기자 dionys@donga.com

Copyright © 스포츠동아. All rights reserved. 무단 전재, 재배포 및 AI학습 이용 금지

공유하기

![강민경, 짧은 치마 입고 왜 그래…명불허전 매력 [DA★]](https://dimg.donga.com/a/158/89/95/1/wps/SPORTS/IMAGE/2024/05/17/124973958.1.jpg)

![이미주·영탁 MC로…‘벌거벗은 세계사’ 확 달라졌네 [DA:투데이]](https://dimg.donga.com/a/232/174/95/1/wps/SPORTS/IMAGE/2026/02/23/133403646.1.jpg)

![서효림, 은은한 속옷 시스루…두바이 여신 등장 [DA★]](https://dimg.donga.com/a/232/174/95/1/wps/SPORTS/IMAGE/2026/02/20/133390128.1.jpg)

![한효주, 군인 출신 父 반전 실력…“엄마만 잘하는 줄” [SD셀픽]](https://dimg.donga.com/a/232/174/95/1/wps/SPORTS/IMAGE/2026/02/20/133389362.1.jpg)

![박민영, 독하게 돌아왔다…위하준·김정현 홀린 치명적 ‘세이렌’ [종합]](https://dimg.donga.com/a/232/174/95/1/wps/SPORTS/IMAGE/2026/02/23/133403858.1.jpg)

![송혜교, 파격 숏컷도 청순하게…독보적 미모 [DA★]](https://dimg.donga.com/a/232/174/95/1/wps/SPORTS/IMAGE/2026/02/21/133393690.1.jpg)

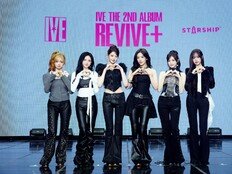

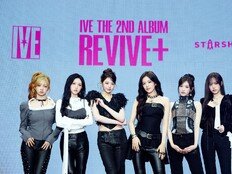

![달라진 아이브, 새롭다…공주 이미지 벗어던지고 ‘세계관 확장’ (종합)[DA:현장]](https://dimg.donga.com/a/232/174/95/1/wps/SPORTS/IMAGE/2026/02/23/133403784.1.jpg)

![유소영, 샤워타월 흘러내릴라…아찔한 호텔 셀카 [DA★]](https://dimg.donga.com/a/232/174/95/1/wps/SPORTS/IMAGE/2026/02/20/133389454.1.jpg)

![헬스하는 장원영, 하의가 반전…사랑스러워 [DA★]](https://dimg.donga.com/a/232/174/95/1/wps/SPORTS/IMAGE/2026/02/20/133390001.1.jpg)

![전지현, 복근+레깅스 美쳤다…40대 중반 안 믿겨 [화보]](https://dimg.donga.com/a/72/72/95/1/wps/SPORTS/IMAGE/2026/02/20/133391974.1.jpg)

![기희현 군살 제로 수영복 자태, 놀라워 [DA★]](https://dimg.donga.com/a/72/72/95/1/wps/SPORTS/IMAGE/2026/02/22/133395234.1.jpg)

![“…남녀 알몸 혼탕”, ‘김지민♥’ 김준호 말에 홍인규 충격 (독박투어4)[TV종합]](https://dimg.donga.com/a/72/72/95/1/wps/SPORTS/IMAGE/2026/02/22/133394792.1.jpg)

![기희현 군살 제로 수영복 자태, 놀라워 [DA★]](https://dimg.donga.com/a/140/140/95/1/wps/SPORTS/IMAGE/2026/02/22/133395234.1.jpg)

![채정안, 48세 안 믿겨…하와이 해변 홀린 탄탄 각선미 [DA★]](https://dimg.donga.com/a/140/140/95/1/wps/SPORTS/IMAGE/2026/02/21/133393738.1.jpg)

![송혜교, 파격 숏컷도 청순하게…독보적 미모 [DA★]](https://dimg.donga.com/a/140/140/95/1/wps/SPORTS/IMAGE/2026/02/21/133393690.1.jpg)

![장예원 주식 대박 터졌다, 수익률 무려 323.53% [DA★]](https://dimg.donga.com/a/110/73/95/1/wps/SPORTS/IMAGE/2023/12/01/122442320.1.jpg)

댓글 0